分布式计算背后的隐藏成本

中国IDC圈3月16日报道,随着互联网的兴起,传统的IT应用架构开始改变,从串行演变成以并行计算为主,与之匹配的服务器架构也从垂直延展的大机器演变成服务器叠加集群。现有的分布式计算架构技术的实现是通过软件并行计算的支持,服务器平台可以通过大量单机成本比大机器低得多的起步价,快速实现应用上线,并在用户量爆发时,通过服务器叠加方式实现扩容。

由于纵向拓展可优化空间太小(单台服务器的性能上限很明显),分布式系统强调横向扩展、横向优化,当分布式集群计算资源不足时,就要往集群里面添加服务器,来不停地提升分布式集群的计算能力。

软硬件成本知多少?

出于成本的考虑,很多大规模的分布式系统一般采用廉价的PC服务器,而不是大型的高性能服务器,但是问题随之而来,等同能力的计算资源,分布式系统的成本一定会低很多吗?

我们可以来做一道算术题,如果将一台具有64GB内存、8个CPU的机器升级为一台拥有512GB内存和32个CPU的服务器,这台机器的总成本大约为10万美金,这显然是一次典型的Scale up升级。

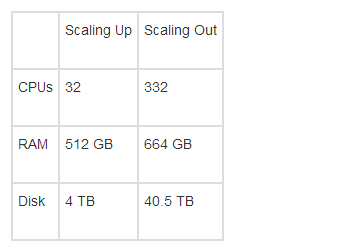

而如果使用scale out的形式,使用大量廉价的服务器来组件系统,这笔投资可以购买83台1U服务器。同样的投资,它们获得的资源分别如下:

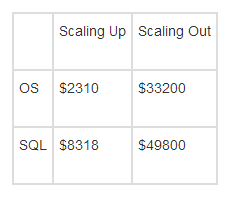

而如果加上微软的商业授权软件,成本大致如下:

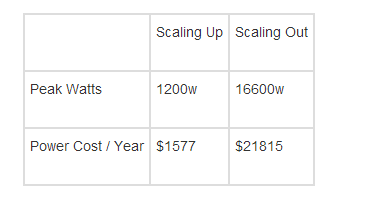

此外,电费消耗对比如下:

由此,我们可以从数字层面看到直观的对比,scale up和scale out都是可选的方案。当然,这涉及到用户具体要解决的问题,你的资源(如资金,软件)等情况。这样看来,只有在使用开源软件时,scale out才有较为明显的优势,因为scale out意味着较少的硬件投入,以及较高的软件授权成本。

开源就能解决成本问题?

开源并不等于免费,为83台服务器配备一个系统运维人员的工作,一年的费用基本上可以购买一台性能足够强大的服务器了,而其它的硬件投入,比如负载均衡、网络等的投入,还有数据中心的费用,7U的服务器虽不便宜,但比83个1U服务器要便宜多了。

说到这里不能不提到这几年大力推广去IOE的阿里,阿里在用开源替代IOE的进程中,差不多花了三年的时间。回首这几年的工作,按照阿里自己的总结来看,开源只是解决了入水时候的零成本问题,而后期在驾驭它的时候你必须面临很高的运维以及发展的成本。

并且,在这一过程中,阿里的相关技术人员因IT技能的需求不同,也出现 了较大的调整,比如从注重Oracle DBA人才调整为MySQL或其他开源数据库DBA人才,机房维护的规模也大大提高。

很多人都觉得采用开源的基于x86的分布式计算可以节省很多成本,至少从普适的采购价格上看, 这一点也许成立的,但这是建立在你有完备的技术人才储备的基础上,否则为了使用开源,你可能要额外的招聘相关领域的人才,从而可能让最后使用的成本核算看上去并不如预期。

因此,如果企业采用开源的分布式系统,需要很强的技术团队才能Hold住,如果你没有做好准备,必须慎之又慎——采用开源技术是否对自己的业务有利,自己当前的人才与技能储备是否可以有效支撑起这项工程?尤其是系统规模越大,涉及的业务越多的时候。