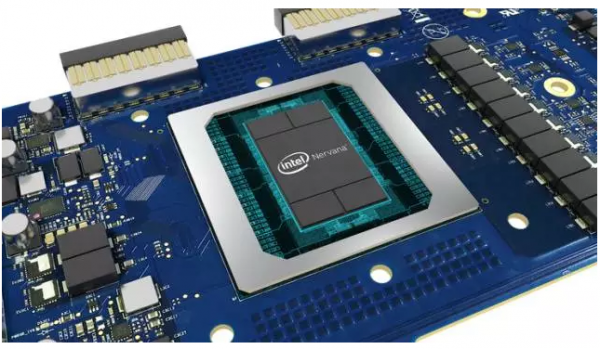

英特尔年底推神经网络处理器 2020年深度学习性能提100倍

英特尔已经准备好在2017年年底推出人工智能芯片。

英特尔CEO Brian Krzanich 昨天说,Facebook在英特尔新芯片的发布上提供了帮助。

Krzanich写道:“当我们将新一代AI硬件推向市场时,我们很高兴Facebook能够提供密切合作并共享其技术见解。英特尔发言人写信给《财富》杂志的一封电子邮件上说,两家公司正在合作,但他们没有确立正式的合作伙伴关系。

英特尔 Nervana 神经网络处理器的来自英特尔在2016年收购的芯片初创公司Nervana Systems。该收购旨在帮助英特尔创建自主的半导体技术,这些技术可以满足像深度学习这样的需要大量的计算机处理才能创建可以在大量数据中发现和反应模式的软件的任务。

在没有AI优化芯片的情况下,像沃尔玛这样希望在其内部数据中心开展深度学习任务的公司已经转向与构建图形处理单元(GPU)的Nvidia等英特尔的竞争对手。

随着对人工智能变得火热及其成为大生意的潜力不断增长,英特尔的新芯片代表了该公司面临的一个关键时刻,该公司已经错过了此前的移动计算技术趋势。

英特尔新芯片项目的领导者Naveen Rao说:“英特尔这样的公司不会经常发布新的产品。但是, “这真的是计算历史上的一个重要时刻。”

根据《财富》的报道,Nervana的CEO Rao说,英特尔最终将会以两种不同的方式向消费者售卖这一芯片。

一种方法是,英特尔将向希望在自己的数据中心运行深入学习项目的客户销售一些数据中心设备,其中包含几个新的Nervana神经网络处理器以及英特尔的CPU。

其次,客户还可以通过英特尔的云数据中心租用芯片,这与Nvidia公司销售其AI定制GPU的方式相似。

英特尔不会单独出售芯片本身,Rao说。他解释说,运行AI项目并不像仅仅将新的处理器安装到计算机那样简单。他表示,英特尔新的数据中心设备是为了适应大多数深度学习项目而设计的,并且那些刚刚涉足这一领域的公司也可以使用。

最终,英特尔可能会开发一个更可自定义的版本AI数据中心盒子,但现在它坚持使用其一体化软件包。

“这只是一个起点”,Rao说。 “我预计未来会有一个具有即插即用模块的生态系统。”

Naveen Rao撰文解读英特尔神经网络处理器四大关键技术特征

昨天,英特尔®Nervana™神经网络处理器负责人Naveen Rao在官网上撰文,解读了即将于年底推出的新芯片的技术特征,以下是详细介绍:

Naveen Rao:

正如英特尔首席执行官布Brian Krzanich今天早些时候在华尔街日报的D.Live活动中讨论的那样,英特尔将很快会出货世界上第一批从头至尾专为人工智能打造的系列处理器——英特尔®Nervana™神经网络处理器系列(以前称为“Lake Crest”)。这个处理器系列的研发已经有3年多的时间,作为开发团队的代表,我想分享一下这一世界第一款神经网络处理器背后的动机和设计的初衷。

深度学习的计算需求要求对围绕支持AI计算的硬件有一些新的思维。为此,我们设计了一个名为“英特尔®Nervana™神经网络处理器(英特尔®Nervana™NNP)”的深度学习新芯片。

英特尔Nervana NNP是专为深度学习设计的架构。这种新架构的目标是提供深度学习所需的灵活性,以支持所有深度学习元语(primitives),同时使核心硬件组件尽可能高效。

我们设计了英特尔Nervana NNP,使我们免受现有硬件的限制,因为这些硬件并不是明确设计为AI的。

1. 新的内存架构旨在最大限度地提高硅计算的利用率

矩阵乘法和卷积是深度学习核心的一些重要原语。这些计算与通用的工作负载不同,因为操作和数据移动在很大程度上是先天知道的。因此,Intel Nervana NNP没有标准的缓存层次结构,片上存储器是由软件直接管理的。更好的内存管理使芯片能够在每个裸片上实现大量计算的高水平利用,这意味着深度学习模型训练可以更快地完成。

2. 实现AI模型可扩展性的新水平

采用高速片上和片外互连设计,Intel Nervana NNP可实现大量双向数据传输。一个具体的设计目标是实现真正的模型并行性,其中神经网络参数分布在多个芯片上。这使得多个芯片充当一个可以容纳更大型号的大型虚拟芯片,从而允许客户从其数据中获取更多洞察力。

3. 高度数值并行性:Flexpoint

单个芯片上的神经网络计算主要受电源和存储器带宽的限制。为了实现神经网络工作负载的更高的吞吐量,除了上述内存创新之外,我们还发明了一种名为Flexpoint的新数字格式。 Flexpoint允许将标量计算实现为定点乘法和加法,同时允许使用共享指数的较大动态范围。由于每个电路较小,这导致了芯片上的并行性的大幅度增加,同时降低了每次计算的功率。

4. 性能

当下的AI革命实际上是计算上的演进。自集成电路的发明以来,英特尔一直是推进计算极限的核心。我们拥有行业和研究方面的早期合作伙伴,他们正在与我们一起走在这个旅程中,共同促成第一个商业神经网络处理器,并对各行各业都产生积极的影响。我们有一个产品路线图,能让我们超过了我们去年设定的目标,在2020年,将深度学习训练的性能提升100倍。