分解云基础设施的必要性

今天的数据基础设施,无论是在本地还是在云中,通常都基于通用的体系结构,这些体系结构利用预先配置的计算和存储资源分配来满足各种应用程序的工作负载需求。随着这些数据密集型应用程序在更大范围内的扩展,一刀切的基础设施在性能、容量和可伸缩性方面出现不足,难以满足不同的应用程序需求。因此,需要一种更新、更灵活的资源分配方法来提高业务效率。

分解计算和存储资源的需求现在是IT优先考虑的问题,这样组织就可以节省资金并提高硬件资源的利用率。要通过优化应用程序部署来实现这些收益,关键的任务是使计算资源和存储资源能够彼此独立地伸缩。通过抽象、配置和改进的flash SSD管理,需要在存储节点本身上运行的专门软件,以充分利用组成存储资源池的高性能和网络化非易失性内存Express (NVME™)-SSD。共享存储资源还可以使用RESTful应用程序编程接口(API)连接到自动化容器编排框架。

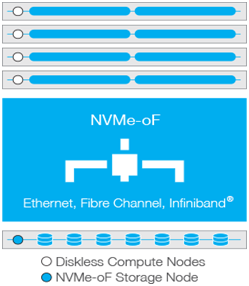

存储软件现在可以使用网络协议将存储从计算节点分离出来,而fabric上的NVME (NVME- oF™)已迅速成为首选协议。它具有流线型、高性能和低延迟,使其成为构建更现代、更敏捷和更灵活的数据中心的有价值的组件。

行业的挑战

现有数据中心通常将直接连接存储(DAS)用于云部署,因为DAS成本低且简单,是目前部署的最流行的存储体系结构。将存储作为DAS模型的一部分嵌入到服务器中还可以提高总体性能和数据访问。然而,DAS的权衡是,CPU和存储资源在环境中紧密地锁在一起,限制了通常会导致存储过量供应的容量和资源利用率,并增加了存储开销和总拥有成本(TCO)。

开发云基础设施的数据中心架构师必须采取额外的设计步骤来克服DAS的许多限制,比如处理服务器中未充分利用的SSD和CPU,这些CPU需要更高的存储性能或容量。为适应云基础设施中的峰值工作负载而过度配置整个数据中心是昂贵的,并且限制了执行弹性伸缩的能力,或者在部署时,会导致资源利用率不足(峰值工作负载除外)。

云中的存储分解

由于广泛采用了两项关键技术:

(1). 10/25/100千兆以太网(GbE)网络连接和任何高性能网络协议,解决IT资源分解的挑战变得更容易了;

(2). 支持基于闪存的SSD在网络上通信的NVME-oF规范,提供了几乎相同的高性能、低延迟优势,就像基于NVME的SSD是本地附加的,或者在某些工作负载下,提供了更好的性能。

NVME- oF旨在解决与DAS体系结构相关的低效问题,方法是将高性能NVME SSD资源从计算节点分离出来,并使它们作为网络附加的共享资源跨网络基础设施可用。池提供了为数据中心内的每个服务器上的每个应用程序工作负载提供适当数量的存储或计算的能力。当与自动化编制框架(如Kubernetes®和OpenStack®)集成时,在工作负载高峰期间,池从较低优先级的应用程序中借用计算资源。虽然这种方法类似于iSCSI等其他块存储技术,但是使用NVME-oF池闪存可以以更低的延迟访问资源,供不同的主机共享。

图1展示了一个DAS体系结构,它使用更多的节点来获得高计算能力和存储容量,但是容易受到资源搁浅的影响

图2表示了一个分解的体系结构,它在类似于das的性能下共享快速NVME存储,节点更少,更容易管理,也更划算

解集的好处

从基于DAS的存储架构迁移到分解的,基于云的共享存储模型(图2)具有多种优势,可显着提高CPU和SSD利用率,从而无需过度构建或过度配置资源以满足峰值应用程序工作负载需求。这种存储资源与计算服务器的分离提供了广泛的财务,运营和性能优势,可以在迁移到云基础架构时保持良好状态。改进包括:

产能利用率

将存储资源与服务器分离的能力允许为每个计算节点和每个工作负载应用正确的容量级别,从而减少了在每个服务器中过多提供存储的需要。

服务器利用率

随着时间的推移,不同的应用程序对计算的需求不同,昂贵的CPU资源可能会被搁浅。Disaggregation为使用更少的计算节点处理I/ o密集型应用程序分配低延迟flash提供了灵活性。分解和NVME-oF的组合通过提高CPU的总体利用率、在不过度配置的情况下最大化存储容量,以及在需要时实现额外的计算节点来解决搁浅的资源问题。

延迟性能

通过NVME-oF进行分解,使延迟与直接连接的驱动器几乎没有区别,并将物理驱动器抽象到一个高性能池中,使flash能够在工作负载实例之间共享。

网络级机会

Disaggregation还允许创建更强大的web规模的云,在这些云中,可以在数据中心中使用大量的云计算资源,并根据跨特定无状态、有状态和批处理应用程序的需要或服务交付策略使用和转移这些资源。

空间、动力和冷却要求

通过分解,资源利用率将会飙升,从而减少对更多空间、电力或冷却需求的需求,从而减少存储开销和TCO。

实时VM迁移,无需移动数据

在软件定义的数据中心中,由于各种原因(负载平衡、维护等),虚拟机(VM)经常需要从一个物理服务器转移到另一个物理服务器。在分解的体系结构中,当虚拟机迁移到其他位置时,数据可以保留在其受保护的位置。仅仅移动虚拟机就简化了这个过程,并且降低了对数据的风险。

组织正在采用云架构,以帮助最大限度地提高数据中心内计算和存储资源的灵活性、可伸缩性和利用率。基于DAS体系结构的传统软件定义存储(SDS)云模型在共享方面不如分解方法有效,导致计算和存储容量利用率较低,并降低了总体经济性能。

当将NVME- oF协议添加到混合协议中时,通过将高性能NVME SSD从计算节点分离出来并使它们可以在网络上共享,可以更好地处理与DAS体系结构相关的限制和低效。

最终的想法

下一代以性能为中心、对延迟敏感的应用程序现在已经成为当今云基础设施规划和运营的一部分,这要求IT组织重新考虑他们的数据中心存储策略。这些策略正逐渐转向共享基础设施和云编排,以便为每个应用程序工作负载分配适当的存储和性能。因此,云中的分解存储正在成为首选的、成本高效的模型。这场运动的核心是对基于NVME的闪存和使基于云的分解成为现实的NVME框架的更高需求。

关于作者:Joel Dedrick是东芝的KumoScale™共享加速存储软件的副总裁兼总经理。作为一名执行技术专家,Dedrick先生拥有超过20年的经验,将有前景的技术转变为公共,私营和初创公司的领先产品。他的专业领域包括存储,网络,半导体和专用计算架构。 Dedrick拥有内布拉斯加大学电子工程学士学位,以及南方卫理公会大学电子工程硕士学位,主修数字信号处理(DSP)。

相关阅读:

电信、腾讯云、魅族等被纳入电信业务经营不良名单

微软重磅推出云计算与软件服务,为何云服务备受国内外企业追捧?

2019年世界性的大数据中心扩张

凡本网注明来源非中国IDC圈的作品,均转载自其它媒体,目的在于传递更多信息,并不代表本网赞同其观点和对其真实性负责。